取得圖片中可能的目標的位置資訊

要讓模型吐出圖片中目標的座標位置資訊,常用的方法是使用目標檢測 (object detection) 的模型,這些模型通常可以同時預測目標的類別 (class) 和座標位置 (bounding box)。

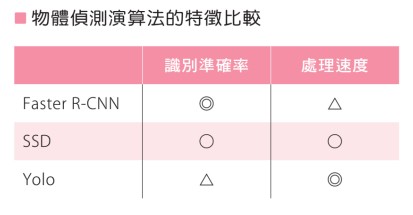

常用的目標檢測模型有 YOLO (You Only Look Once)、SSD (Single Shot MultiBox Detector) 以及 Faster R-CNN。在 TensorFlow 中,可以使用 TensorFlow Object Detection API 來訓練和使用這些模型。

訓練模型時需要給予圖片和相對應的座標位置(Annotation), 訓練好之後, 就可以得到模型預測目標的座標位置.

如果你要找的目標是特定類型, 也可以使用像 RetinaNet, FPN 等特定目標檢測模型, 它們通常都能很好的偵測目標並輸出相對應的座標位置資訊。

常見的模型介紹

常見的物體偵測模型,包括:

- Single Shot MultiBox Detector (SSD):這是一個快速的目標檢測模型,可以在計算資源有限的環境中運行。

- You Only Look Once (YOLO):這也是一個快速的目標檢測模型,可以在實時應用中使用。

- Faster R-CNN:這是一個經典的目標檢測模型,在准確性和效率之間取得了很好的平衡。

- RetinaNet:這是一個新的目標檢測模型,在准確性和效率上都有很好的表現。

這些模型都是廣泛使用的,可以根據您的需求和硬體資源選擇適當的模型。

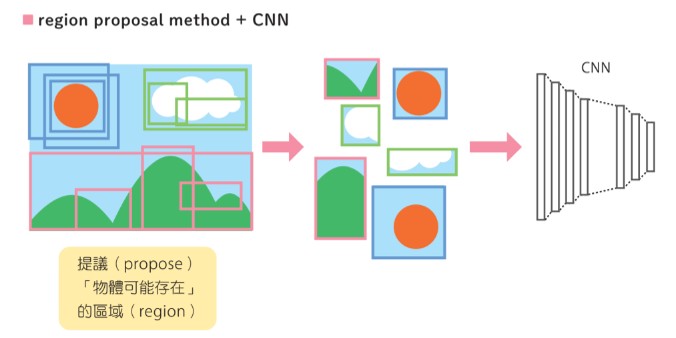

區域建議網絡(Region Proposal Network, RPN) 是一種卷積神經網絡,它的主要功能是在輸入圖像中產生候選的目標區域。這些候選區域之後可以被傳入一個分類器來預測目標的類別和座標位置。

區域建議網絡通常由兩個部分組成: 一個卷積層,負責對輸入圖像進行特徵提取;一個全卷積層,負責對每個位置產生候選區域。

Faster R-CNN介紹

Faster R-CNN 是一種目標檢測模型,其基礎概念為使用卷積神經網絡(CNN)的特徵提取器 (feature extractor) 和基於區域的建議網絡 (region-based proposal network) 來預測目標的類別和座標位置。

Faster R-CNN 的架構由三個部分組成:

- 一個區域建議網絡 (RPN) : 這部分主要負責對圖像產生區域建議,並且預測每個建議區域中是否包含目標。

- 一個卷積神經網絡特徵提取器 (CNN feature extractor) :這部分主要負責對輸入圖像進行預處理,提取出高維度的特徵。

- 一個分類器 (classifier) : 這部分主要負責對建議區域進行分類,並預測每個區域中目標的類別和座標位置。

為了能夠得到目標的座標位置資訊,Faster R-CNN 首先使用 RPN 來產生區域建議,並且預測每個建議區域中是否包含目標。接著,將這些建議區域輸入分類器,並預測每個區域中目標的類別和座標位置。

RPN原理

RPN 通常使用一種稱為 anchor 的技巧,設置預先定義好的候選區域 (如長方形),在輸入圖像中做卷積運算,預測每個 anchor 是否包含目標,並且預測每個目標的座標位置。

在 RPN 中使用 anchor 的方法是:

- 對於輸入圖像中的每個位置,預先放置一些 anchor

- 對於每個 anchor,預測它是否包含目標,並且預測目標的座標位置。

Anchor 技巧的目的在於可以減少目標檢測的計算量,因為只需要在少數候選區域中進行目標檢測,而不是在整張圖像中進行目標檢測。 並且因為anchor的設定, 更能更好的適用不同的目標。

下圖為一個檢測流程的範例:

簡單範例

以下是使用 TensorFlow Object Detection API 訓練和使用 Faster R-CNN 的示例代碼:

# 安裝 TensorFlow Object Detection API pip install tensorflow-object-detection-api

# 引入需要的庫 import tensorflow as tf from object_detection import model_hparams from object_detection import model_lib # 設置訓練參數 hparams = model_hparams.create_hparams() hparams.num_classes = NUM_CLASSES # 設置類別數量 hparams.batch_size = BATCH_SIZE # 設置批量大小 # 設置訓練路徑 train_dir = 'path/to/train' # 建立模型 model_fn = model_lib.create_faster_rcnn_model_fn(hparams) # 創建訓練配置 session_config = tf.ConfigProto(allow_soft_placement=True) # 啟動訓練 tf.estimator.train_and_evaluate( model_fn, train_input_fn, eval_input_fn, train_dir, session_config=session_config )