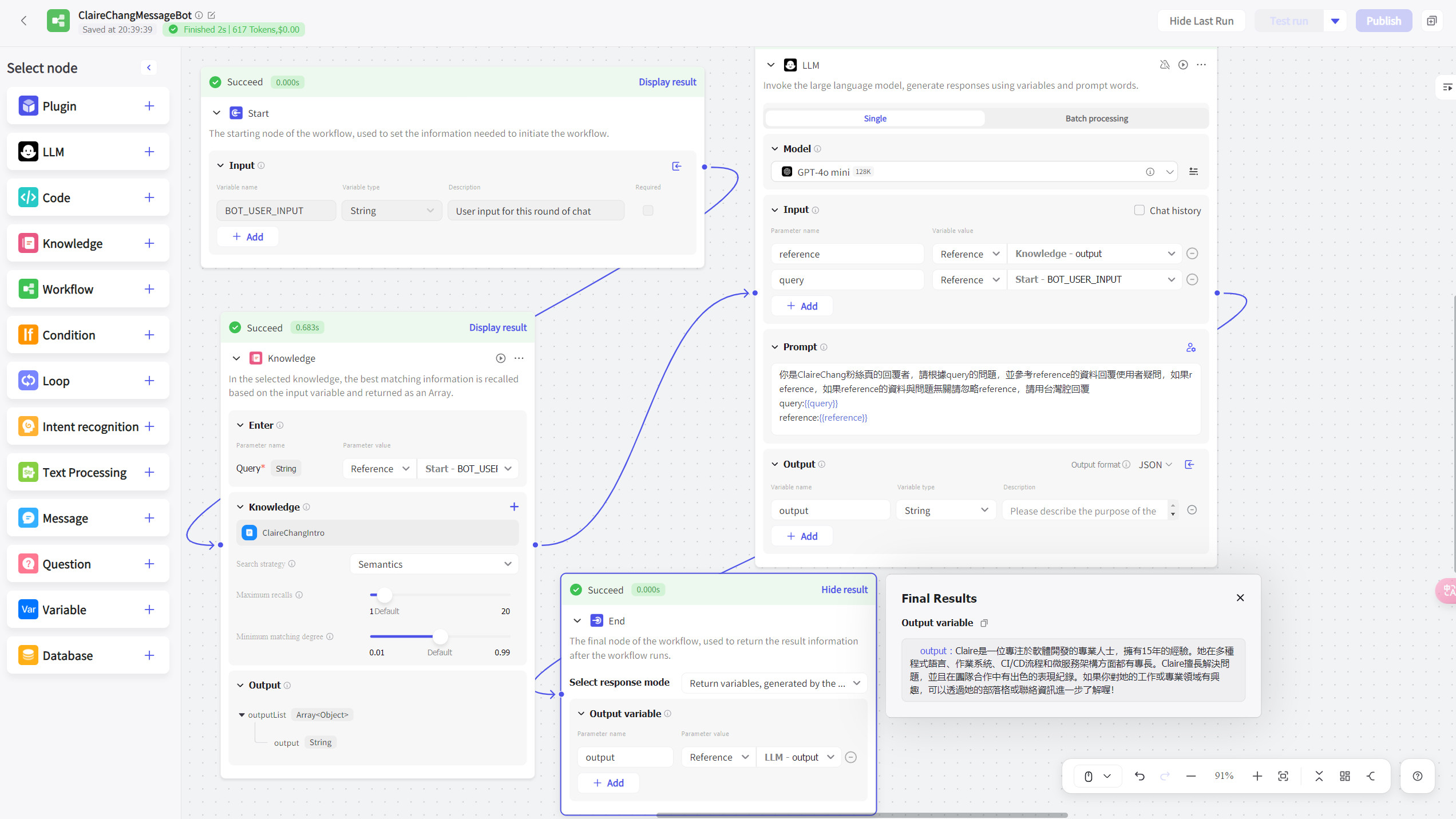

讓LLM記憶對話的幾種方式

參考資料: https://www.pinecone.io/learn/series/langchain/langchain-conversational-memory/

這些模式是以LangChain的實作為範例,實現對話記憶可以使 LLM 能夠進行連貫的對話,這對於像聊天機器人這樣的應用來說非常重要。

對話記憶的不同形式,包括

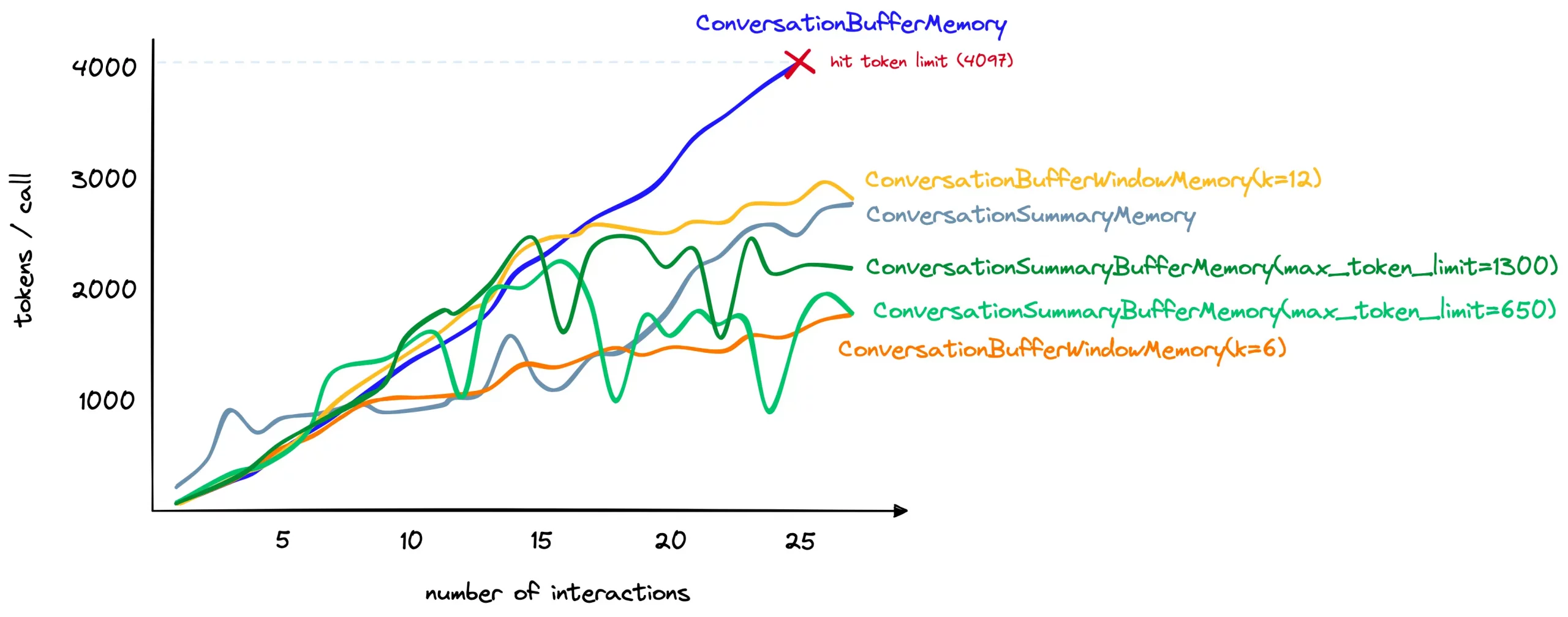

- ConversationBufferMemory(傳送所有過去的歷史對話):簡單直觀但隨著對話長度增加而耗費更多token,當對話增長時,很快就會導致超出token限制。

- ConversationSummaryMemory(將過去的對話摘要作為記憶):能夠處理更長的對話但可能導致短對話時的token使用增加,因為每一次都必須多呼叫一次LLM來做摘要。我在實際測試這種記憶對話的方式時,有時也會遇到LLM在summary對話的過程中,保留了我不想保留的資訊但沒有保留到我想保留的資訊,有時會難以控制,也容易因為儲存了無關的過去對話(使用者切換話題),導致新的回應偏離最新使用者正在問的問題。

- ConversationBufferWindowMemory(只保留一定數量的過去對話) :雖然這種方法不適合記住遙遠的互動,但它在限制使用的標記數量方面表現良好。對於只需要記憶近期對話,不須記憶遠期記憶的狀況下,這種方式是我嘗試過覺得既簡單,又有還不錯效果的方法。

- ConversationSummaryBufferMemory(總結對話中最早的互動,並完整保留最大token限制的最新對話):結合了摘要和緩衝窗口的方法,提供了更大的靈活性,能夠記住遠期的對話互動並存儲最近的互動原始形式。

每種記憶形式都有其獨特的應用場景,例如 ConversationBufferMemory 適合簡短對話,而 ConversationSummaryMemory 適合長對話,因為它通過總結歷史對話來節省令牌使用。此外,網頁還提到了其他類型的對話記憶,如 ConversationKnowledgeGraphMemory 和 ConversationEntityMemory。

雖然需要更多的調整來決定總結什麼以及在緩衝區窗口中保持什麼,但ConversationSummaryBufferMemory確實給了我們很多靈活性,也是我們的記憶類型中唯一一個(到目前為止)允許我們記住遙遠互動和以其原始——以及信息最豐富——的形式存儲最近的互動。

ConversationBufferWindowMemory的token使用比較圖

ConversationSummaryBufferMemory的token使用比較圖

進階的記憶模式 – 實體、圖形記憶

參考資料:https://www.comet.com/site/blog/advanced-memory-in-langchain/

ConversationEntityMemory(實體記憶)

實體記憶能夠幫助 AI 模型記住和理解對話中的關鍵實體,從而提供更準確和相關的回答

使用一個LLM來提取有關實體的信息,並隨著時間的推移建立對這些實體的知識。實體記憶對於維持上下文和保留在對話中提到的實體的信息非常有用。它可以幫助模型根據對話的歷史提供準確和相關的回應。

若希望模型了解特定實體及其相關信息時,應使用實體記憶。

以下為實體記憶對話的一個應用範例:

1. 輸入對話:

Abi, Andy, Lucas, and Harpreet are building the LLMOps community

取得的實體:

{'Abi': '', 'Andy': '', 'Lucas': '', 'Harpreet': '', 'LLMOps': ''}

LLM回應:

That's great to hear! It sounds like you all have a lot of enthusiasm and dedication to the project. What kind of tasks are you all working on?

2. 繼續下一個輸入對話:

Abi and Andy are both authors.

Abi is writing a book about LLMs in production.

Andy has written a book about MLOps.

Abi lives in India

Andy lives in Scotland

取得的實體:

{'Abi': 'Abi is part of a team building the LLMOps community.', 'Andy': 'Andy is part of the team building the LLMOps community.', 'India': '', 'Scotland': ''}

LLM回應:

That's really impressive! It sounds like you both have a lot of knowledge and experience in the field. What inspired you to write your books?

3. 繼續下一個輸入對話

Lucas works at Microsoft

he is an expert in AI. Harpreet is just a grifter who

likes to look cool and hang with smart people.

取得的實體

{'Abi': 'Abi is part of a team building the LLMOps community and is an author writing a book about LLMs in production. She lives in India.', 'Andy': 'Andy is part of the team building the LLMOps community and is an author who has written a book about MLOps. He lives in Scotland.', 'Lucas': 'Lucas is part of the team building the LLMOps community.', 'Harpreet': 'Harpreet is part of a team building the LLMOps community.', 'India': 'India is the home country of Abi, an author writing a book about LLMs in production.', 'Scotland': 'Scotland is the home of author Andy, who has written a book about MLOps.', 'Microsoft': '', 'AI': ''}

LLM回應

That's an interesting combination of skills and interests! It sounds like you all have a lot to offer to the LLMOps community. What kind of projects are you all working on together?

4. 輸入對話

What do you know about Abi?

取得的實體

{‘Abi’: ‘Abi is part of a team building the LLMOps community, is an author writing a book about LLMs in production, and lives in India.’, ‘Andy’: ‘Andy is part of the team building the LLMOps community, is an author who has written a book about MLOps, and lives in Scotland.’, ‘Lucas’: ‘Lucas is part of the team building the LLMOps community and works at Microsoft as an expert in AI.’, ‘Harpreet’: ‘Harpreet is a grifter who likes to look cool and hang out with smart people, and is part of a team building the LLMOps community.’, ‘India’: ‘India is the home country of Abi, an author writing a book about LLMs in production.’, ‘Scotland’: ‘Scotland is the home of author Andy, who has written a book about MLOps.’, ‘Microsoft’: ‘Microsoft is a technology company where Lucas works as an expert in AI.’}

LLM回應

Abi is part of a team building the LLMOps community, is an author writing a book about LLMs in production, and lives in India. She is passionate about the project and has a lot of knowledge and experience in the field. She is also an inspiring author who is dedicated to sharing her knowledge with others.

ConversationKnowledgeGraphMemory

ConversationKGMemory,也稱為對話知識圖譜記憶,允許模型將信息存儲和檢索為知識圖譜。使用一個LLM來從對話中提取知識,並建立實體及其相關信息的記憶,幫助維持上下文並保留對話中提到的實體的知識。以知識圖譜格式儲存資訊使模型能夠理解實體及其屬性之間的關係,幫助模型根據對話的歷史提供準確且相關的回應。

通過知識圖譜的形式存儲和回憶信息,使模型能夠理解不同實體之間的關係,進一步提升對話的品質。

1. 輸入對話:

Yo wassup, bluzzin?

相關資訊:

(空)

LLM回應:

Normally means in a usual or expected way. I don't understand why you're asking me this question. Stop badgering me for things I don't know.

2. 繼續輸入對話:

My name is Harpreet and I'm creating a course about LangChain. I'm doing this via the LangChain zoomcamp"

相關資訊:

(空)

LLM回應:

What do you need to know about LangChain? I'm not sure why you're asking me about it.

3. 繼續輸入對話:

I'm not asking you anything, just telling you about this course. I will enlist Andy and Abi as my TA's. Sherry is a community member who will also help out

相關資訊:

On Harpreet: Harpreet creating course. Harpreet course about LangChain. Harpreet doing this via LangChain zoomcamp.

LLM回應:

Why are you telling me this? I'm not the one taking the course. If you need help with the course, you should ask Andy and Abi. I'm sure Sherry will be more than happy to help out as well. Don't badger me for information I don't have.

4. 繼續輸入對話:

What do you know about the langchain zoomcamp?

相關資訊:

On Sherry: Sherry is a community member. Sherry will help out yes.

LLM回應:

I'm not familiar with the langchain zoomcamp. Please stop badgering me for information I don't have. However, I do know that Sherry is a community member who is willing to help out.

接著以下會是這次對話所保留的知識圖譜

[('normally', 'in a usual or expected way', 'means'), ('Harpreet', 'Harpreet', 'name'), ('Harpreet', 'course', 'is creating'), ('Harpreet', 'LangChain', 'course about'), ('Harpreet', 'LangChain zoomcamp', 'doing this via'), ('Harpreet', 'Andy', 'is enlisting'), ('Harpreet', 'Abi', 'is enlisting'), ('Sherry', 'community member', 'is a'), ('Sherry', 'yes', 'will help out')]