甚麼是Transformer 模型

Transformer 模型是一種神經網路,藉由追蹤序列資料中的關係,學習上下文之間的脈絡及意義,就如同句子中的每一個字。

NVIDIA – 何謂 Transformer 模型?

Transformer 模型是使用一套不斷發展,稱為注意力(attention)或自我注意力(self-attention)的數學技術,它可偵測一個系列中以微妙方式相互影響和相互依賴的資料元素,甚至是模糊的資料元素。

Google 在 2017 年的一篇論文中,首次提到 Transformer 模型是迄今發明出最新且最強大的模型之一。Transformer 模型在推動機器學習不斷進步,有些人稱其為 Transformer 人工智慧。

Transformer 模型是一種深度學習模型,由Vaswani等人於2017年在論文 “Attention is All You Need” 中提出。它最初是為了解決序列到序列的任務,例如機器翻譯,但後來已被用於多種自然語言處理(NLP)任務,並成為了許多先進模型,如 BERT 和 GPT 等的基礎。

「Transformer 模型讓我們可以做到自我監督學習,以及快速發展人工智慧。」NVIDIA 創辦人暨執行長黃仁勳在 2022 年舉行的 GTC 大會主題演講中表示。

Transformer 模型的主要特點包括:

- Self-Attention Mechanism:

- Self-Attention 使模型能夠權衡輸入序列中不同位置的重要性,從而更好地捕捉序列中的依賴關係。

- 透過計算 Query、Key 和 Value 的點積來得出每個單詞對其他單詞的注意力分數。

- Multi-Head Attention:

- Transformer 使用多個 Self-Attention 頭,讓模型能夠同時關注多個位置,從而獲取更豐富的信息。

- Positional Encoding:

- 因為 Transformer 模型沒有內建的順序感知機制,所以要通過加入位置編碼來獲取序列中單詞的位置信息。

- Feed-Forward Neural Networks:

- 每個 Transformer Block 包含一個全連接的前饋神經網絡,用於進行非線性轉換。

- Layer Normalization:

- 每個子層(例如 Self-Attention、Feed Forward Neural Network)有一個 Layer Norm,用於穩定模型的訓練。

- Residual Connections:

- 模型中使用了殘差連接,這有助於緩解梯度消失問題,並允許模型設計得更深。

Transformer 模型由編碼器和解碼器組成。編碼器用於處理輸入序列,而解碼器則用於生成輸出序列。在許多情況下,例如當模型用於文本生成或者語言模型訓練時,可能只會使用到解碼器。

這個模型由於其高效的平行計算和強大的表達能力,已成為當前自然語言處理領域的主流架構。

Transformers 模型原理

Transformers 模型使用鍵值結構(Key-Value Structure)進行自注意力(self-attention),這是它們在處理序列資料中的重要組成部分。以下是如何在 Transformers 中使用鍵值結構進行自註意力機制的簡要說明:

- 輸入表示:在Transformers模型中,輸入序列被編碼為一組向量,通常稱為「嵌入」(embeddings)。這些嵌入向量包括查詢(query)、鍵(key)和值(value)表示。每個嵌入支持都用於不同的目的。

- 計算注意力分數:對於每個位置或單詞,模型計算查詢與所有鍵顯示之間的相似度分數。這是透過點積或其他方法來完成的,目的是簡單查詢與鍵的關聯程度。分數用於表示每個位置對其他位置的關注度。

- 應用softmax函數:為了獲得標準化的注意力權重,模型要應用softmax函數計算上一步的分數。這將確保注意力重總和等於1,因此它們可以被視為機率分佈。

- 計算加權值:使用softmax歸一化的注意力權重來加權值分配。這意味著每個位置的值都會根據注意力權重進行加權組合,以產生新的表示。

- 輸出:最後,透過將加權值相加,模型產生了更新的表示,這些表示包含了上下文資訊和關注重點。這些更新的表示被傳遞到下層或用於任務特定的操作。

總的來說,自注意力機制允許Transformer模型根據輸入資料的不同部分之間的關係來動態調整其內部表示。鍵值結構在此過程中起到關鍵作用,因為它們允許模型在查詢和按鍵之間建立關聯,便於在產生新的表示時聚焦於相關的資訊。這使得Transformer模型能夠在各種自然語言處理任務中表現出色,包括機器翻譯、文字生成、文字分類等。

論文內容探究

在 2021 年 8 月的一篇論文中,史丹佛大學的研究人員將 Transformer 模型稱為「基礎模型」,他們認為這些模型推動了人工智慧的典範移轉。他們寫道:「在過去幾年,基礎模型之規模和範圍擴大了我們對可能性的想像。」

On the Opportunities and Risks of Foundation Models

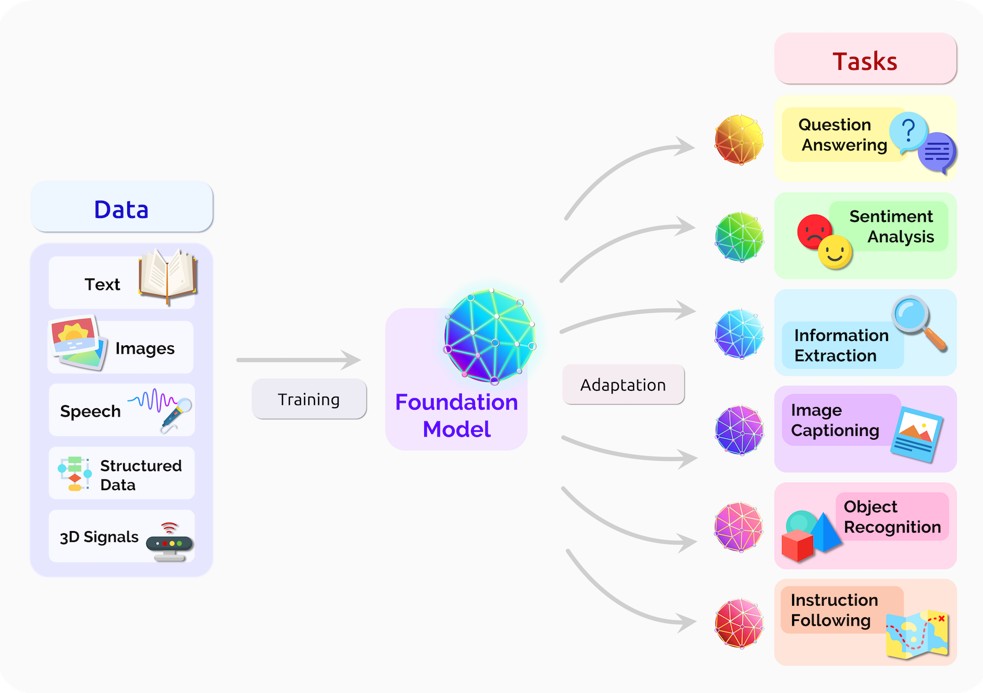

這份報告探討了一種新興的人工智慧(AI)系統建構範式 , 稱為「基礎模型」 。

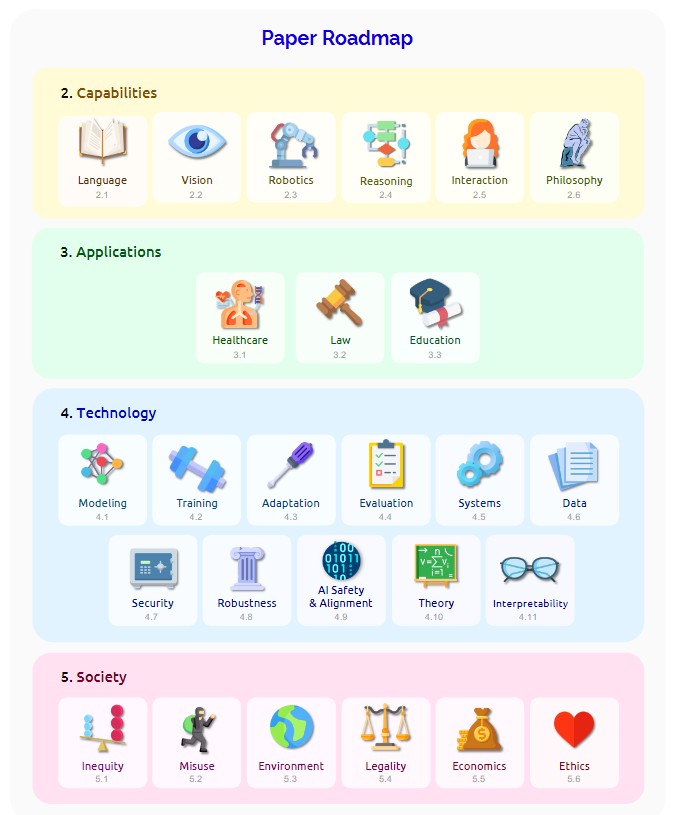

基礎模型是指任何一個在廣泛數據上進行訓練(通常使用大規模的自監督訓練) , 可以適應各種下游任務的模型 。 這份報告探討了基礎模型的機會和風險, 包括模型的能力 、 技術原則 、 應用以及社會影響 。 基礎模型的重要性在於它們的規模和範疇 , 從而改變了我們對於可能性的想像 。

然而 , 基礎模型的崛起也伴隨著風險 , 因為它們的缺陷可能會傳遞給所有適應的下游模型 。 由於我們目前對基礎模型的工作方式 、 失敗時機和能力缺乏清晰的理解 , 因此需要深度跨學科的合作來解決這些問題 。

報告還討論了基礎模型的社會影響 , 包括社會不平等 、 濫用 、 經濟和環境影響 、 法律和道德考慮等方面 。 基礎模型的部署對人們的生活產生了深遠的影響 , 因此需要負責任地預測和應對這些道德和社會考慮 。 報告還強調 , 基礎模型的研究和部署是兩個不同的階段 , 並且需要更嚴格的測試和審核 , 以確保它們的可靠性和安全性 。

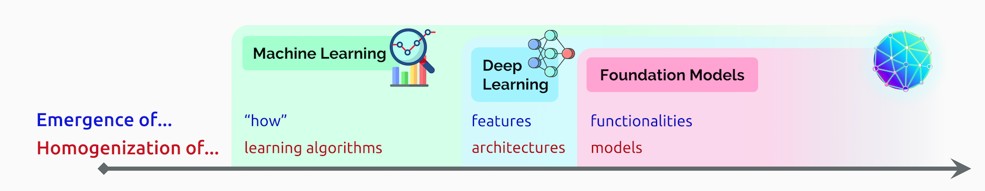

基礎模型的兩個重要特點: Emergence 、Homogenizatio

基礎模型的興起帶來了「Emergence(新興特性)」和「Homogenizatio(同質化)」,它們使AI系統更強大,但也需要謹慎使用,因為基礎模型的缺陷會傳承到所有適應的下游模型中。需要跨學科合作來深入研究基礎模型的工作,以理解它們的工作方式、失敗情況和潛在能力。

- Emergence : 意味著基礎模型的行為是由模型自動產生而不是明確設計的 , 這使得我們難以預測它們的所有行為 。

- Homogenization: 則表示基礎模型的使用在各種應用中變得非常相似 , 這帶來了高度的效益 , 但也可能導致一個模型的缺陷影響所有相關的應用 。

Homogenization和Emergence在某種程度上令人擔憂地互相影響。Homogenization在數據稀缺的特定任務領域中可能帶來巨大優勢。然而,任何模型中的缺陷都可能被所有的適應模型所繼承。由於基礎模型的力量更多地來自於它們的Emergence特性,而非其明確結構,這使得當前的基礎模型難以被理解,並可能出現意外的故障模式。由於Emergence使基礎模型的能力和缺陷變得不可預知,因此對這些模型進行大規模的Homogenization會帶來風險。

基礎模型的應用範圍

此外,報告指出,基礎模型生態系統包括從數據創建到部署的多個階段,並強調人在整個過程中的關鍵作用。數據的創建、整理、訓練和適應是基礎模型生態系統的重要組成部分,需要特別關注資料的品質、道德和法律要求。報告呼籲在基礎模型的各個階段都應該實施嚴格的監測和負責任的實踐。

基礎模型的社會影響

基礎模型在AI系統中的崛起帶來了深遠的社會影響。主要問題是:它們造成了哪些具體影響?相關的考慮包括社會不平等的加劇、對經濟和環境的影響、誤導信息的擴散、法律和道德問題,以及政治經濟層面的挑戰。由於基礎模型的多功能性和不可預知性,我們面臨如何負責任地處理其帶來的道德和社會問題。

再者,我們需要考慮基礎模型的整體生態系統,從數據生成到實際部署。這一系統包括數據收集、訓練、適應和部署等多個階段,並強調了人在此過程中的重要性。

此外,有一系列基於通用模型的新興AI系統,如BERT、DALL-E和GPT-3。這些模型雖然帶來了新的可能性,但也伴隨著同質化和其他風險。要應對這些挑戰,需要多學科的合作。

隨著基礎模型的興起,AI正朝向更泛化的方向發展。其中,「Emergence」和「Homogenization」成為了核心概念。在這發展過程中,如何減少風險、確保AI的安全性和道德考慮,都是我們面臨的主要挑戰。

基礎模型對社會的影響涵蓋了多個範疇,如社會不平等、經濟效應、環境問題、信息誤用、法律後果、倫理挑戰和政治經濟。在研究和部署這些模型時,我們需要承擔相應的社會責任,並加強測試與審查。同時,我們必須深入理解基礎模型的整個生態系統,從數據收集到模型的部署,人在這過程中扮演著核心角色。為了降低潛在的不良效應,我們需要更加重視數據品質、模型使用方式以及相關的倫理考量。